A/Bテストを効果的に行うための6つのヒント | アドビUX道場 #UXDojo

デザインを直感に頼る必要はありません。ユーザー体験を本当に改善するデザインを判断したり、コンバージョンを高めるために使えるデー タを入手する手段があります。そのひとつであるA/Bテストは、2種類のデザインを無作為にユーザーに表示し、パフォーマンスを判定するテクニックです。

A/Bテストには多くの利点があります。Booking.comでリードデザイナーを務めるゾーイ・ギレンウォーターは、A/Bテストを利用すると、デザインに関する意思決定に、外部の人も参加できることを学びました。すなわち、デザインチームだけでなく、ユーザーが直接デザインに意見できるのです。

「デザイナーの個人的な好み、偏見、エゴで決定するのではなく、ユーザーがデザインに直面した時の振る舞いを『投票』として扱うのがA/Bテストで す」とギレンウォーターは説明します。「A/Bテストが開発プロセスにしっかりと統合されていれば、役員が高みから変更を指示することも防げます。意見や 仮定が問題なのではありません。それらを、A/Bテストを含むさまざまな角度から得たデータを使って検証することが、成功率をはるかに高めるのです」

では、効果的なA/Bテストを行うにはどのようにすればよいのでしょうか。また、取得したデータをどのようにして解析し、洞察を得ればよいのでしょ うか。この答えを探るために、5人のUXデザイナーに、A/Bテストを計画して実行する際に最も気をつけるべきことについて聞きました。

1. トラフィックに基づく戦略

UXデザイナーのマリーザ・モービーは、A/Bテストには、Webサイトのトラフィックに基づいた戦略が必要だと考えています。

「1日のユニークユーザー数が5,000以上のように、高いトラフィックがある場合は、プロトタイプやデザインを短時間に連続でテストして、継続的 に新しいデータを引き出せます」と彼女は説明します。「高トラフィックサイトの場合は、できるだけ変更箇所を抑えたA/Bテストを準備するべきです。そう すれば、どの変更がもっとも重要な指標に影響を与えているのか、絞り込みやすくなります」

1日のユニークユーザー数が300を下回るような低トラフィックのサイトには、変更が大掛かりでインパクトの高いA/Bテストの実施をモービーは勧 めます。「一度にひとつのテストだけ行い、2つの完全に異なる2つのデザインを比較します。そうすれば、どちらのデザインがより魅力的であるのかを明確に できます」

一方、ギレンウォーターは、統計的に意味のある結果を得るには十分なトラフィックが必要であると語ります。必要なトラフィック量とテストの実行期間は、A/Bテストのオンラインツールを使って計算できます。

「トラフィック量が少なすぎるサイトでテストしたり、テストの実行期間が短かすぎると、取得したデータに誤りが生じる可能性が高まります」とギレン ウォーターは警告します。「誤ったデータに基づいてデザインを決定するのは、データをまったく使わずに決定するよりも危険なことです」

2. しっかりとした仮説を立てる

A/Bテストの土台は、しっかりとしたユーザー中心の仮説を立てることにあるとギレンウォーターは考えています。

「強固な仮説がなければ、すべてダメになってしまいます」と彼女は言います。「良い仮説は、変更を行う理由、つまり、どのようなユーザーの問題を解 決しようとしているのかを示してくれます。何を変更しようとしていて、それが誰のためであり、ユーザーにどのような影響を与えるのか、さらに、その結果を どのように測定するのかを説明できる仮説が必要です。仮説がなければ、盲目的なテストを実施することになって、どう取り扱うべきか見当のつかないデータだ けが山積みになるでしょう」

有力な仮説がない場合は、起こるべき成功を示す指標を評価することができず、代わりに、自身が想定している仮定に都合の良いデータだけを選ぶことになりかねないとギレンウォーターは警告します。

「テストを実行できるから実行するという考えは捨てましょう。デザイン変更に価値があることを強く支持する仮説がある場合のみ、テストを実行するべきです」

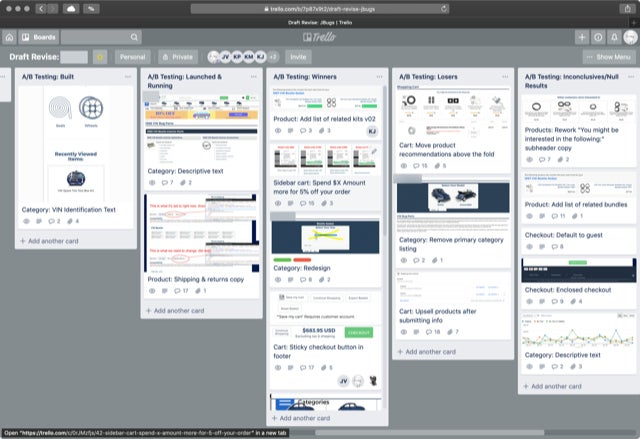

3. テスト案に優先順位をつける

インタラクションデザインのコンサルティング会社Draftを経営し、『Value-based Design』を執筆したデザイナーのニック・ディサバトは、 業界内のA/Bテストの成功率は、約12.5パーセントであると指摘します。彼が経営するDraftでは成功率が60パーセント超、 ConversionXLでは成功率が90パーセント以上です。なぜこのような差が生まれるのでしょうか?ディサバトは、何をテストするのか、それをいつ 行うべきかを理解しているからだと言います。

「ボタンの色や見出しをテストするだけでは不十分です。洗練された最適化を行いたいなら、まずテストすべき項目を調査してから、テスト案に優先順位をつけます。最適化の作業において、何をテストすべきか把握していることはもっとも重要です」

ディサバトの提案は、テスト案ごとに「実行可能性」「影響の大きさ」「戦略との整合性」を評価することです。

実行可能性: テスト準備の難易度は? テストのために必要になる開発作業、プロトタイプ、ワイヤーフレームはあるか?

影響の大きさ: この変更が指標にどの程度の影響を与えると予測されるか?ページを表示した瞬間に目立つ主要な要素を変更しようとしているのか?それとも目に留まりにくい小さな要素を変更しようとしているのか?

戦略との整合性: テスト案はビジネスの長期的な戦略にどれくらい則しているのか?

「各項目のスコアを合計して、点数の高いテスト案から順に並べてみると、何をなぜテストするのか把握できます。新しいテスト案を思いついたときにはスコアを付けて、数か月ごとに全部まとめて再評価しましょう」とディサバトは勧めます。

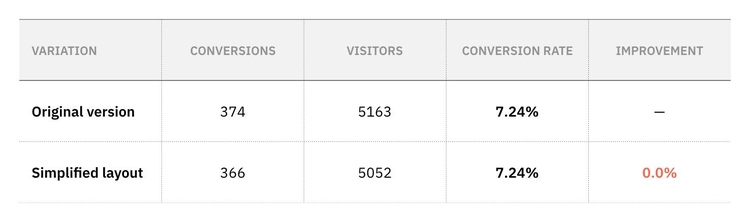

4. 失敗したテストを受け入れる

結果を見て「なるほど」と思えるA/Bテストであれば理想的ですが、実際には、ほとんどのA/Bテストが統計的に有意な結果を得ることに失敗しています。この状況についてIBM Watson Mediaで上級デザインマネージャーを務めるUXデザイナーのゾルタン・コーリンは実験の延長を検討するという選択肢もあると話しています。

「もう少しトラフィックが得られれば、統計的に有意な領域に入るかもしれません。ただしある時点を過ぎたら、素晴らしい案に見えていたデザインでは コンバージョンを改善できないと認める必要があります。仮説に自信があれば、デザインのやり直を考えるかもしれません。もしかすると、デザインの差異が小 さすぎてにユーザーが気付かず、有意な結果を導き出せなかったのかもしれません。全体的なビジョンに立ち戻り、ほかのデザイン案を練り直してみることもで きるでしょう」

A/Bテストが仮説を完全に否定したとしても、諦めることはありません。コーリンは、少なくとも時間内に結果が判明したことを指摘します。さらにユーザー調査を行えば、その理由やほかの機会を見つけ出すことも可能でしょう。

「A/Bテストは検証ツールですから、実際には失敗しようがありません」とコーリンは勇気づけます。「自分の好むデザインが常に良い結果を生むとは 限りませんが、UI変更による影響を測定し、データに基づいた決定を下すことはできます。それに、違いが見られないという結果は全く問題ありません。自分 の好みのデザインをリスクなしで実装できるという科学的根拠を与えてくれるのですから」

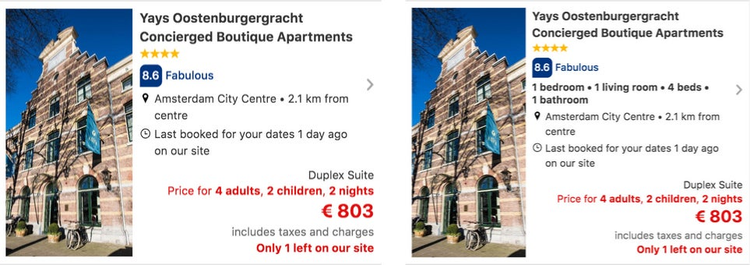

ギレンウォーターはこの意見に同意しています。Booking.comではおおよそ10回中9回はテストに失敗しています。業界ではごく普通の失敗率です。しかし、失敗したテストでも、非常に価値の高い情報を得られると言います。

「失敗したテストは、何かが機能していないことを示すという点において成功しています」と彼女は指摘します。「結果から導かれるデータは、次に行う テストの仮説を構築するのに役立ちます。それは次のテストが成功する確率を高めます。それがBooking.comではすぐ準備できる小規模テストの実施 が多い理由です。すぐに失敗して学び、次のテストに移れれば、より素早く成功に近づけます」

5. A/Bテストはすべてを語らない

A/Bテストから得たデータがすべてを語るわけではないと、心に留めておくことが大切だとギレンウォーターは言います。

「ユーザー体験の解明に使用するべき洞察のたったひとつを得たにすぎません。同じデータがいくつかの異なるストーリーを語ることだってあり得ます。 他の調査から得た洞察により裏付けられた仮説と共にテストを開始しなければ、データがどのようなストーリーを示そうとしているのか、確実に理解することは できません」

たとえば、変更を適用したらページの滞在時間が減少したとします。これはどう解釈するとよいのでしょうか?様々な理由を編み出して、良い結果にも悪い結果にも結び付けることができるでしょう。

「仮説は、変更がページの滞在時間にどのような影響があるかを示してくれますが、それに加えて、他の定量データやユーザーテストのような定性的な調査のデータを使用することで、真実に最も近いストーリーを選択できるようになります」とギレンウォーターは提案します。

モービーはこれに同意して、A/Bテストは顧客調査と合わせて行うことで効力を発揮し、ユーザーの特定の行動を理解する役に立つと述べています。

6. ユーザー体験にフォーカスする

A/Bテストは、どのデザインのパフォーマンスが良いのかを、定量的に判断するのに非常に役立つ手法です。とはいえ、ユーザー体験の優劣を判断するにはA/Bテストでは不十分であると、Thomasnet.comでユーザーエクスペリエンス部門のディレクターを務めるジュリアン・ガビリアは指摘します。

「データ駆動型デザインが流行した結果、コンバージョンの最適化をやりすぎて、ユーザー体験をだめにしてしまうWebサイトがますます増えていま す。コンバージョンだけを焦点にすることの問題点は、短期的な利益のために持続的かつ長期的な成長を犠牲にする可能性が高まることです」

この2つのバランスを取るために、Thomasnet.comのチームは、以下に紹介するプロセスに落ち着きました。そのおかげで彼らは、どのよう な種類のA/Bテストを実施する際も、定性的なKPIと定量的なKPIの両方に同じように注意を払うことができるようになっています。

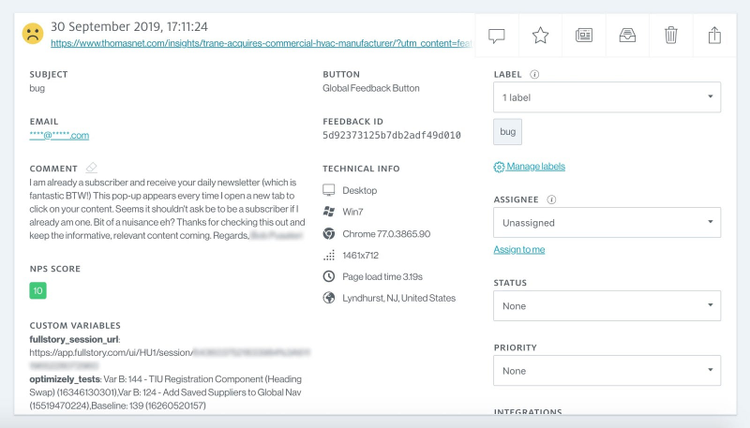

– A/Bテストを定性的データと統合

ガビリアのチームは、A/Bテストを、ユーザーフィードバックおよび録画ツールと深く統合させました。

「そのため、ユーザーがフィードバックを残すたびに、対応するA/Bテストを確認して、そのときユーザーが使っていたバリエーションを、セッション の録画とともに見ることができます。この手順は、データだけでは表面に出てこない問題点や使いづらい箇所を特定するのに非常に有効です」

フィードバックツールを使用して、ユーザーフィードバック、録画URL、テストのリストを管理している

– チーム全体で行う録画レビュー

テストから収集された一連の情報が共有されるように、ガビリア達は週に一回のペースで「game film reviews」と題してレビュー会を開催し、すべての部署のチームメンバーを招待して、その週のテストのユーザー録画を上映します。

「これは、組織として定着させることができた習慣の中で、最も役立つもののひとつになりました」とガビリアは話します。「この会合は、A/Bテスト の定性的な洞察を得るための役に立つだけではありません。多くの場合に熱心な議論が行われて、新しいテストのアイデアや異なる意見を引き出したり、チーム 内の共通理解を深める機会にもなっています」

– ユーザー中心のデザイン原則を守る

ユーザーフィードバックやユーザー録画をどれだけ確認しても、そもそもテストの準備が最高のユーザー体験を意図して行われていなければ、後からできることはほとんどありません。

「ユーザー体験を考え出す際の判断は、ユーザー中心の視点から書かれたThomasnet.com独自の一連のデザイン原則を基準にしています。このデザイン原則は、テスト案からダークパターンを排除し、デザインの変更を、体験全体の改善を目指す持続可能なものに向かわせてくれます。作業時間の削減にも大きく役立っています」

失敗は成功の基

すべてのデザインをA/Bテストで評価することはできません。テストのプロセスに慣れる時間も必要です。ほとんどのテストは失敗するでしょうし、多 くの想定していたことが誤りであることに気づいて葛藤を覚えるかもしれません。それでも諦めずに、失敗したテストからできるだけ多くの価値を引き出す術を 学ぶことが重要です。

A/BテストはUXデザイナーが利用できる強力なツールですが、テスト自体を目的化することなく、常にユーザーを念頭にテストすることを忘れないよ うにしましょう。A/Bテストを適切に行うことができれば、ユーザーのリアルタイムの行動を測定し、ユーザー体験とコンバージョンを大きく改善できるで しょう。